Régression linéaire

Cet article explique ce qu’est la régression linéaire et à quoi elle sert en statistiques. De plus, vous pourrez voir comment les deux types de régression linéaire sont calculés : la régression linéaire simple et la régression linéaire multiple.

Qu’est-ce que la régression linéaire ?

La régression linéaire est un modèle statistique qui relie une ou plusieurs variables indépendantes à une variable dépendante. Autrement dit, la régression linéaire est une technique utilisée pour trouver une équation qui se rapproche de la relation entre une ou plusieurs variables explicatives et une variable de réponse.

Par exemple, l’équation y=2+5x 1 -3x 2 +8x 3 est un modèle de régression linéaire, car elle relie mathématiquement trois variables indépendantes (x 1 , x 2 , x 3 ) avec une variable dépendante (y) et, de plus , la relation entre les variables est linéaire.

Types de régression linéaire

Il existe deux types de régression linéaire :

- Régression linéaire simple : Une seule variable indépendante est liée à une variable dépendante. L’équation de ce type de modèle de régression linéaire est donc de la forme y=β 0 +β 1 x 1 .

- Régression linéaire multiple : Le modèle de régression comporte plusieurs variables explicatives et une variable de réponse. Par conséquent, l’équation de ce type de modèle de régression linéaire est de la forme y=β 0 +β 1 x 1 +β 2 x 2 …+β m x m .

régression linéaire simple

La régression linéaire simple est utilisée pour relier une variable indépendante aux deux variables.

L’équation d’un modèle de régression linéaire simple est une droite, elle est donc composée de deux coefficients : la constante de l’équation (β 0 ) et le coefficient de corrélation entre les deux variables (β 1 ). Par conséquent, l’équation d’un modèle de régression linéaire simple est y=β 0 +β 1 x.

![]()

Les formules pour calculer les coefficients de régression linéaire simple sont les suivantes :

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

Où:

est la constante de la droite de régression.

est la constante de la droite de régression. est la pente de la droite de régression.

est la pente de la droite de régression. est la valeur de la variable indépendante X des données i.

est la valeur de la variable indépendante X des données i. est la valeur de la variable dépendante Y des données i.

est la valeur de la variable dépendante Y des données i. est la moyenne des valeurs de la variable indépendante X.

est la moyenne des valeurs de la variable indépendante X. est la moyenne des valeurs de la variable dépendante Y.

est la moyenne des valeurs de la variable dépendante Y.

La régression linéaire multiple

Dans un modèle de régression linéaire multiple , au moins deux variables indépendantes sont incluses. Autrement dit, la régression linéaire multiple permet de relier de manière linéaire plusieurs variables explicatives à une variable de réponse.

L’équation d’un modèle de régression linéaire multiple est y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Où:

est la variable dépendante.

est la variable dépendante. est la variable indépendante je.

est la variable indépendante je. est la constante de l’équation de régression linéaire multiple.

est la constante de l’équation de régression linéaire multiple. est le coefficient de régression associé à la variable

est le coefficient de régression associé à la variable .

. est l’erreur ou résidu, c’est-à-dire la différence entre la valeur observée et la valeur estimée par le modèle.

est l’erreur ou résidu, c’est-à-dire la différence entre la valeur observée et la valeur estimée par le modèle. est le nombre total de variables dans le modèle.

est le nombre total de variables dans le modèle.

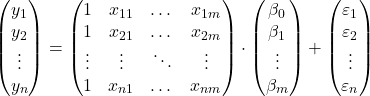

Donc si nous avons un échantillon avec un total de

![]() observations, nous pouvons poser le modèle de régression linéaire multiple sous forme matricielle :

observations, nous pouvons poser le modèle de régression linéaire multiple sous forme matricielle :

L’expression matricielle ci-dessus peut être réécrite en attribuant une lettre à chaque matrice :

![]()

Ainsi, en appliquant le critère des moindres carrés, on peut arriver à la formule pour estimer les coefficients d’un modèle de régression linéaire multiple :

![]()

Cependant, l’application de cette formule est très laborieuse et prend du temps, c’est pourquoi en pratique, il est recommandé d’utiliser un logiciel informatique (tel que Minitab ou Excel) qui permet de créer un modèle de régression multiple beaucoup plus rapidement.

Hypothèses de régression linéaire

Dans un modèle de régression linéaire, les conditions suivantes doivent être remplies pour que le modèle soit valide :

- Indépendance : Les résidus doivent être indépendants les uns des autres. Une manière courante de garantir l’indépendance du modèle consiste à ajouter du caractère aléatoire au processus d’échantillonnage.

- Homoscédasticité : il doit y avoir une homogénéité dans les variances des résidus, c’est-à-dire que la variabilité des résidus doit être constante.

- Non-multicolinéarité : les variables explicatives incluses dans le modèle ne peuvent pas être liées entre elles ou, du moins, leur relation doit être très faible.

- Normalité : les résidus doivent être distribués normalement, ou en d’autres termes, ils doivent suivre une distribution normale de moyenne 0.

- Linéarité : on suppose que la relation entre la variable de réponse et les variables explicatives est linéaire.

A quoi sert la régression linéaire ?

La régression linéaire a essentiellement deux utilisations : la régression linéaire est utilisée pour expliquer la relation entre les variables explicatives et la variable de réponse et, de même, la régression linéaire est utilisée pour prédire la valeur de la variable dépendante pour une nouvelle observation.

En obtenant l’équation du modèle de régression linéaire, nous pouvons savoir quel type de relation existe entre les variables du modèle. Si le coefficient de régression d’une variable indépendante est positif, la variable dépendante augmentera lorsqu’elle augmentera. Tandis que si le coefficient de régression d’une variable indépendante est négatif, la variable dépendante diminuera lorsqu’elle augmentera.

D’autre part, l’équation calculée en régression linéaire permet également de faire des prédictions de valeur. Ainsi, en introduisant les valeurs des variables explicatives dans l’équation du modèle, nous pouvons calculer la valeur de la variable dépendante pour une nouvelle donnée.