Un guide simple sur la validation croisée K-Fold

Pour évaluer les performances d’un modèle sur un ensemble de données, nous devons mesurer dans quelle mesure les prédictions faites par le modèle correspondent aux données observées.

La façon la plus courante de mesurer cela consiste à utiliser l’erreur quadratique moyenne (MSE), qui est calculée comme suit :

MSE = (1/n)*Σ(y je – f(x je )) 2

où:

- n : nombre total d’observations

- y i : La valeur de réponse de la ième observation

- f(x i ) : La valeur de réponse prédite de la i ème observation

Plus les prédictions du modèle sont proches des observations, plus la MSE sera faible.

En pratique, nous utilisons le processus suivant pour calculer le MSE d’un modèle donné :

1. Divisez un ensemble de données en un ensemble de formation et un ensemble de test.

2. Créez le modèle en utilisant uniquement les données de l’ensemble de formation.

3. Utilisez le modèle pour faire des prédictions sur l’ensemble de test et mesurer le MSE du test.

Le test MSE nous donne une idée des performances d’un modèle sur des données qu’il n’a pas vues auparavant. Cependant, l’inconvénient de l’utilisation d’un seul ensemble de tests est que le MSE du test peut varier considérablement en fonction des observations utilisées dans les ensembles de formation et de test.

Une façon d’éviter ce problème consiste à ajuster un modèle plusieurs fois en utilisant à chaque fois un ensemble de formation et de test différent, puis à calculer le MSE du test comme étant la moyenne de tous les MSE du test.

Cette méthode générale est connue sous le nom de validation croisée et une forme spécifique de celle-ci est connue sous le nom de validation croisée k-fold .

Validation croisée K-Fold

La validation croisée K-fold utilise l’approche suivante pour évaluer un modèle :

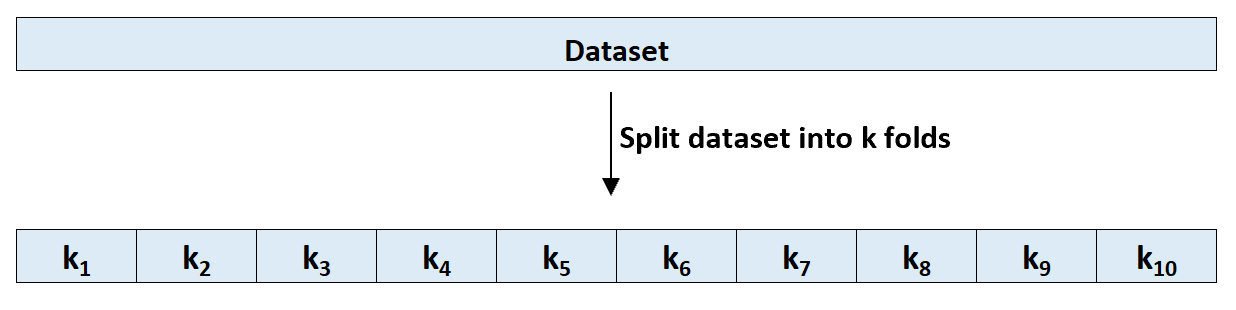

Étape 1 : Divisez aléatoirement un ensemble de données en k groupes, ou « plis », de taille à peu près égale.

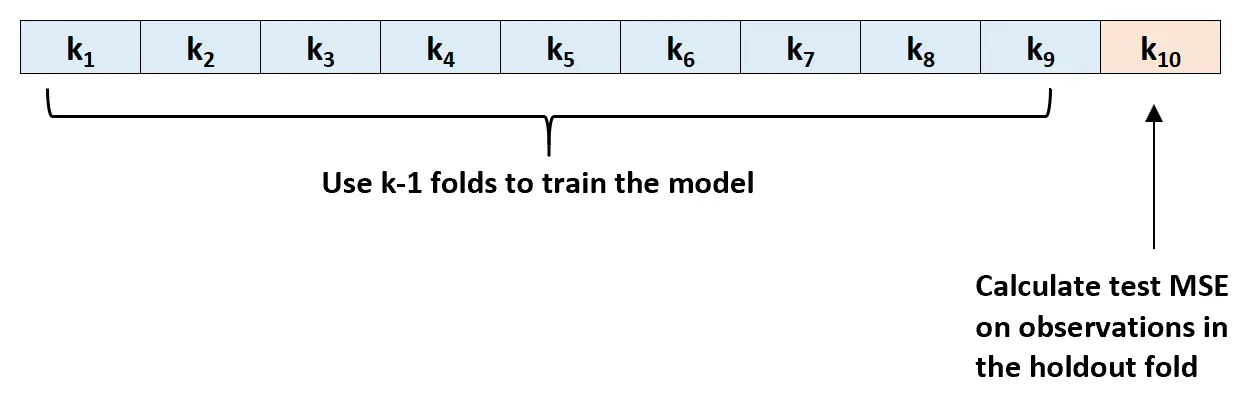

Étape 2 : Choisissez l’un des plis comme ensemble de maintien. Ajustez le modèle sur les plis k-1 restants. Calculez le test MSE sur les observations dans le pli qui a été tendu.

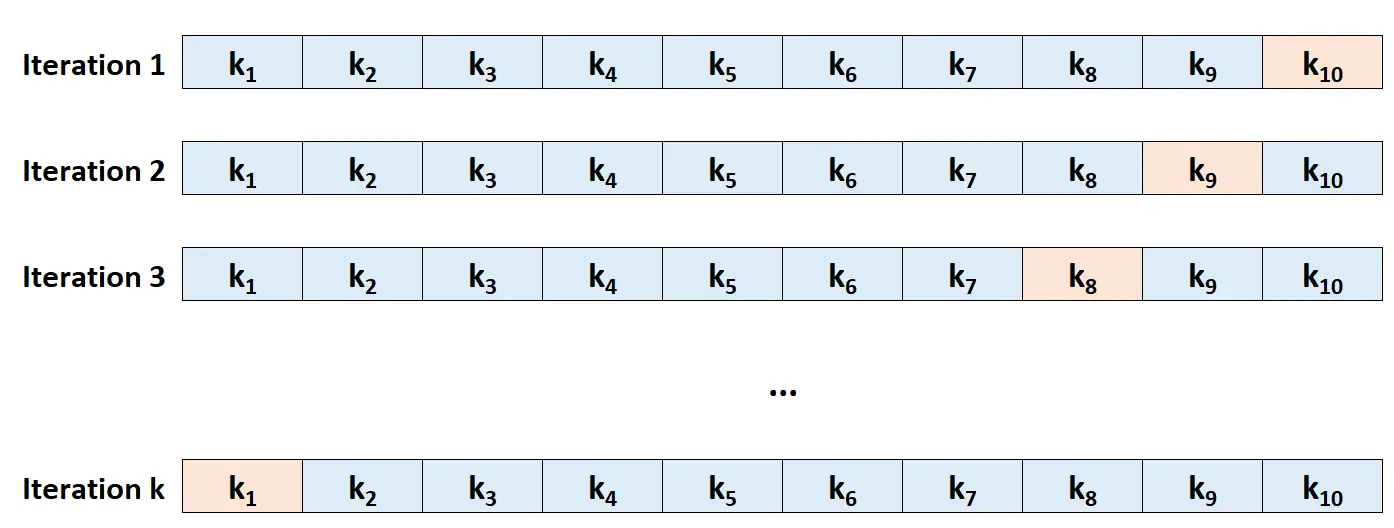

Étape 3 : Répétez ce processus k fois, en utilisant à chaque fois un ensemble différent comme ensemble d’exclusion.

Étape 4 : Calculez le MSE global du test comme étant la moyenne des k MSE du test.

Test MSE = (1/k)*ΣMSE i

où:

- k : Nombre de plis

- MSE i : Tester MSE à la ième itération

Comment choisir K

En général, plus nous utilisons de plis dans la validation croisée k fois, plus le biais du test MSE est faible mais plus la variance est élevée. À l’inverse, moins nous utilisons de plis, plus le biais est élevé mais plus la variance est faible. Il s’agit d’un exemple classique du compromis biais-variance dans l’apprentissage automatique.

En pratique, on choisit généralement d’utiliser entre 5 et 10 plis. Comme indiqué dans An Introduction to Statistical Learning , il a été démontré que ce nombre de plis offre un équilibre optimal entre biais et variance et fournit ainsi des estimations fiables du MSE du test :

Pour résumer, il existe un compromis biais-variance associé au choix de k dans la validation croisée k fois.

En règle générale, compte tenu de ces considérations, on effectue une validation croisée k fois en utilisant k = 5 ou k = 10, car il a été démontré empiriquement que ces valeurs donnent des estimations du taux d’erreur de test qui ne souffrent ni d’un biais excessivement élevé ni d’une variance très élevée.

-Page 184, Une introduction à l’apprentissage statistique

Avantages de la validation croisée K-Fold

Lorsque nous divisons un ensemble de données en un seul ensemble de formation et un seul ensemble de test, le MSE de test calculé sur les observations de l’ensemble de test peut varier considérablement en fonction des observations utilisées dans les ensembles de formation et de test.

En utilisant la validation croisée k-fold, nous sommes en mesure de calculer le MSE du test en utilisant plusieurs variantes différentes d’ensembles de formation et de test. Cela nous permet d’obtenir beaucoup plus de chances d’obtenir une estimation impartiale du MSE du test.

La validation croisée K-fold offre également un avantage informatique par rapport à la validation croisée Leave-One-Out (LOOCV), car elle ne doit s’adapter à un modèle que k fois au lieu de n fois.

Pour les modèles qui prennent beaucoup de temps à s’adapter, la validation croisée k-fold peut calculer le MSE du test beaucoup plus rapidement que LOOCV et dans de nombreux cas, le MSE du test calculé par chaque approche sera assez similaire si vous utilisez un nombre suffisant de plis.

Extensions de la validation croisée K-Fold

Il existe plusieurs extensions de la validation croisée k-fold, notamment :

Validation croisée k fois répétée : c’est là que la validation croisée k fois est simplement répétée n fois. Chaque fois que les ensembles de formation et de test sont mélangés, cela réduit encore davantage le biais dans l’estimation du MSE du test, bien que cela prenne plus de temps à réaliser qu’une validation croisée k fois ordinaire.

Validation croisée Leave-One-Out : Il s’agit d’un cas particulier de validation croisée k fois dans lequel k = n . Vous pouvez en savoir plus sur cette méthode ici .

Validation croisée k-fold stratifiée : il s’agit d’une version de validation croisée k-fold dans laquelle l’ensemble de données est réorganisé de telle manière que chaque pli soit représentatif de l’ensemble. Comme l’a noté Kohavi , cette méthode tend à offrir un meilleur compromis entre biais et variance par rapport à la validation croisée ordinaire k-fold.

Validation croisée imbriquée : c’est ici que la validation croisée k fois est effectuée dans chaque pli de validation croisée. Ceci est souvent utilisé pour effectuer le réglage des hyperparamètres lors de l’évaluation du modèle.