Score F1 vs précision : lequel devriez-vous utiliser ?

Lors de l’utilisation de modèles de classification dans l’apprentissage automatique, deux mesures que nous utilisons souvent pour évaluer la qualité du modèle sont le score F1 et la précision .

Pour les deux métriques, plus la valeur est élevée, plus un modèle est capable de classer les observations en classes.

Cependant, chaque mesure est calculée à l’aide d’une formule différente et son utilisation présente des avantages et des inconvénients.

L’exemple suivant montre comment calculer chaque métrique dans la pratique.

Exemple : Calcul du score et de la précision F1

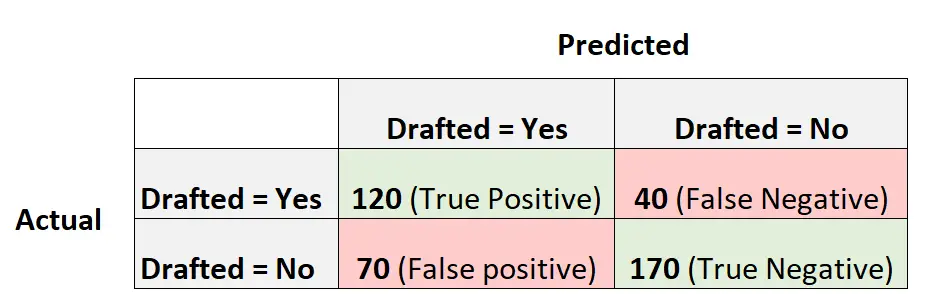

Supposons que nous utilisions un modèle de régression logistique pour prédire si 400 joueurs de basket-ball universitaires différents seront recrutés ou non dans la NBA.

La matrice de confusion suivante résume les prédictions faites par le modèle :

Voici comment calculer diverses métriques pour la matrice de confusion :

Précision : corriger les prédictions positives par rapport au total des prédictions positives

- Précision = Vrai Positif / (Vrai Positif + Faux Positif)

- Précision = 120 / (120 + 70)

- Précision = 0,63

Rappel : Corrigez les prédictions positives par rapport au total des positifs réels

- Rappel = Vrai Positif / (Vrai Positif + Faux Négatif)

- Rappel = 120 / (120 + 40)

- Rappel = 0,75

Précision : pourcentage de toutes les observations correctement classées

- Précision = (Vrai positif + Vrai négatif) / (Taille totale de l’échantillon)

- Précision = (120 + 170) / (400)

- Précision = 0,725

Score F1 : moyenne harmonique de précision et de rappel

- Score F1 = 2 * (Précision * Rappel) / (Précision + Rappel)

- Score F1 = 2 * (0,63 * 0,75) / (0,63 + 0,75)

- Note F1 = 0,685

Quand utiliser le score F1 par rapport à la précision

Il y a des avantages et des inconvénients à utiliser le score et la précision F1.

Précision :

Pro : Facile à interpréter. Si l’on dit qu’un modèle est précis à 90 %, on sait qu’il a correctement classé 90 % des observations.

Inconvénient : Ne prend pas en compte la manière dont les données sont distribuées. Par exemple, supposons que 90 % de tous les joueurs ne soient pas recrutés dans la NBA. Si nous avions un modèle qui prédit simplement que chaque joueur ne sera pas repêché, le modèle prédirait correctement le résultat pour 90 % des joueurs. Cette valeur semble élevée, mais le modèle est en réalité incapable de prédire correctement les joueurs qui seront repêchés.

Résultats F1 :

Pro : Prend en compte la manière dont les données sont distribuées. Par exemple, si les données sont fortement déséquilibrées (par exemple, 90 % de tous les joueurs ne sont pas repêchés et 10 % le sont), alors le score F1 fournira une meilleure évaluation des performances du modèle.

Inconvénient : Plus difficile à interpréter. Le score F1 est un mélange de précision et de rappel du modèle, ce qui le rend un peu plus difficile à interpréter.

En règle générale :

Nous utilisons souvent la précision lorsque les classes sont équilibrées et qu’il n’y a aucun inconvénient majeur à prédire les faux négatifs.

Nous utilisons souvent le score F1 lorsque les classes sont déséquilibrées et qu’il existe un sérieux inconvénient à prédire les faux négatifs.

Par exemple, si nous utilisons un modèle de régression logistique pour prédire si une personne a ou non un cancer, les faux négatifs sont vraiment mauvais (par exemple, prédire qu’une personne n’a pas de cancer alors qu’elle en a réellement un) donc le score F1 pénalisera les modèles qui ont trop de faux négatifs. plus que la précision.

Ressources additionnelles

Régression vs classification : quelle est la différence ?

Introduction à la régression logistique

Comment effectuer une régression logistique dans R

Comment effectuer une régression logistique en Python