Introduction à la régression linéaire multiple

Lorsque nous voulons comprendre la relation entre une seule variable prédictive et une variable de réponse, nous utilisons souvent la régression linéaire simple .

Cependant, si nous souhaitons comprendre la relation entre plusieurs variables prédictives et une variable de réponse, nous pouvons utiliser la régression linéaire multiple .

Si nous avons p variables prédictives, alors un modèle de régression linéaire multiple prend la forme :

Y = β 0 + β 1 X 1 + β 2 X 2 + … + β p X p + ε

où:

- Y : La variable de réponse

- X j : la j ème variable prédictive

- β j : L’effet moyen sur Y d’une augmentation d’une unité de X j , en maintenant fixes tous les autres prédicteurs

- ε : Le terme d’erreur

Les valeurs de β 0 , β 1 , B 2 , … , β p sont choisies en utilisant la méthode des moindres carrés , qui minimise la somme des carrés des résidus (RSS) :

RSS = Σ(y je – ŷ je ) 2

où:

- Σ : Un symbole grec qui signifie somme

- y i : la valeur de réponse réelle pour la ième observation

- ŷ i : La valeur de réponse prédite basée sur le modèle de régression linéaire multiple

La méthode utilisée pour trouver ces estimations de coefficients repose sur l’algèbre matricielle et nous n’aborderons pas les détails ici. Heureusement, n’importe quel logiciel statistique peut calculer ces coefficients pour vous.

Comment interpréter la sortie de régression linéaire multiple

Supposons que nous ajustions un modèle de régression linéaire multiple en utilisant les variables prédictives , les heures étudiées et les examens préparatoires passés , ainsi qu’une note d’examen variable de réponse.

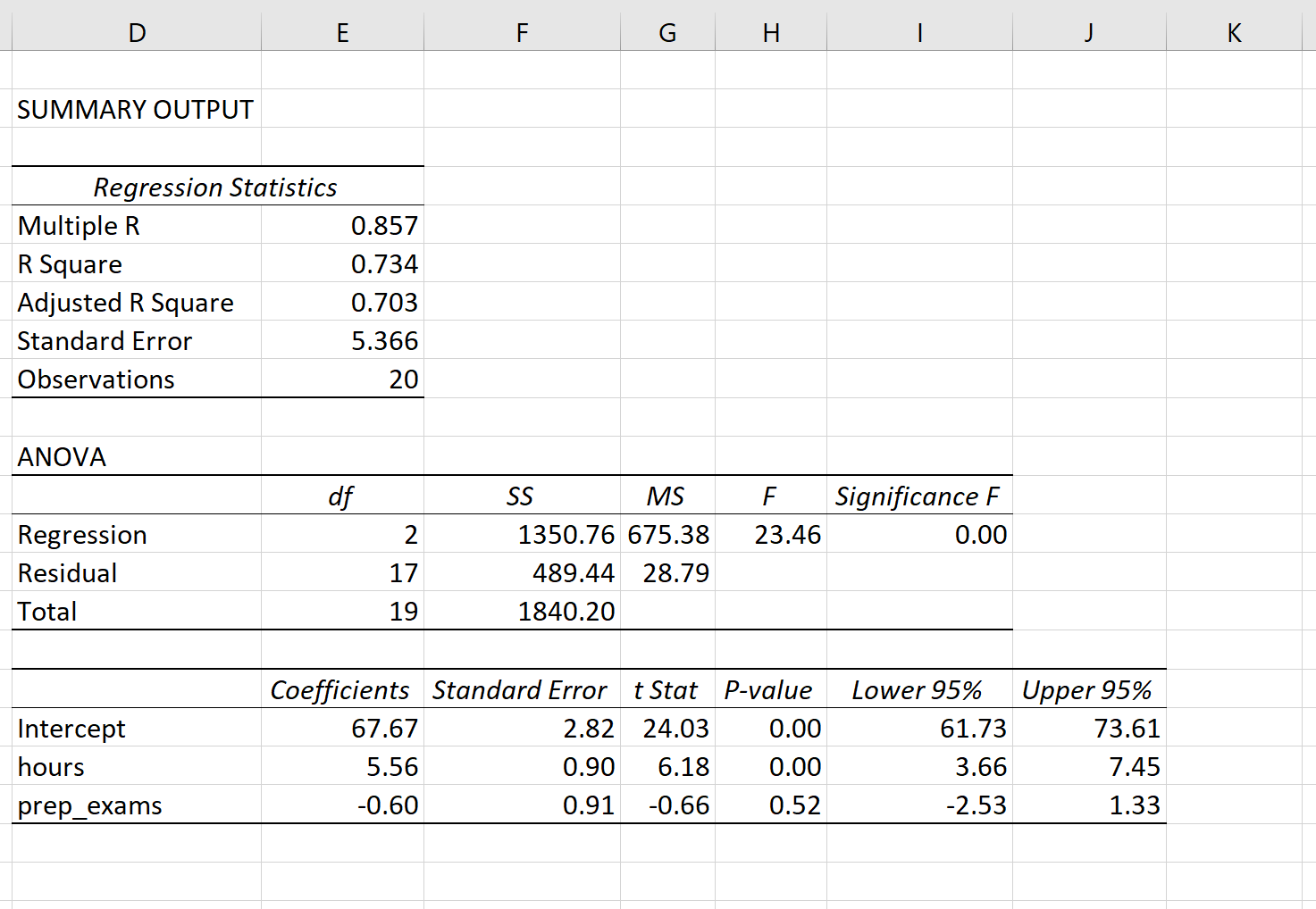

La capture d’écran suivante montre à quoi pourrait ressembler le résultat de la régression linéaire multiple pour ce modèle :

Remarque : La capture d’écran ci-dessous montre la sortie de régression linéaire multiple pour Excel , mais les nombres affichés dans la sortie sont typiques de la sortie de régression que vous verrez en utilisant n’importe quel logiciel statistique.

À partir des résultats du modèle, les coefficients nous permettent de former un modèle de régression linéaire multiple estimé :

Note à l’examen = 67,67 + 5,56*(heures) – 0,60*(examens préparatoires)

La manière d’interpréter les coefficients est la suivante :

- Chaque augmentation supplémentaire d’une unité du nombre d’heures étudiées est associée à une augmentation moyenne de 5,56 points de la note à l’examen, en supposant que les examens préparatoires restent constants.

- Chaque augmentation supplémentaire d’une unité dans les examens préparatoires passés est associée à une diminution moyenne de 0,60 point de la note à l’examen, en supposant que le nombre d’heures étudiées reste constant.

Nous pouvons également utiliser ce modèle pour déterminer la note d’examen attendue qu’un étudiant recevra en fonction du nombre total d’heures étudiées et des examens préparatoires passés. Par exemple, un étudiant qui étudie pendant 4 heures et passe 1 examen préparatoire devrait obtenir un score de 89,31 à l’examen :

Note à l’examen = 67,67 + 5,56*(4) -0,60*(1) = 89,31

Voici comment interpréter le reste des résultats du modèle :

- R-Carré : C’est ce qu’on appelle le coefficient de détermination. C’est la proportion de la variance de la variable de réponse qui peut être expliquée par les variables explicatives. Dans cet exemple, 73,4 % de la variation des résultats aux examens s’explique par le nombre d’heures étudiées et le nombre d’examens préparatoires passés.

- Erreur type : il s’agit de la distance moyenne entre les valeurs observées et la ligne de régression. Dans cet exemple, les valeurs observées s’éloignent en moyenne de 5,366 unités de la droite de régression.

- F : Il s’agit de la statistique F globale pour le modèle de régression, calculée comme MS de régression / MS résiduelle.

- Signification F : Il s’agit de la valeur p associée à la statistique F globale. Cela nous indique si le modèle de régression dans son ensemble est statistiquement significatif ou non. En d’autres termes, cela nous indique si les deux variables explicatives combinées ont une association statistiquement significative avec la variable de réponse. Dans ce cas, la valeur p est inférieure à 0,05, ce qui indique que les variables explicatives, les heures étudiées et les examens préparatoires passés combinés, ont une association statistiquement significative avec le résultat de l’examen.

- Valeurs P du coefficient. Les valeurs p individuelles nous indiquent si chaque variable explicative est statistiquement significative ou non. Nous pouvons voir que les heures étudiées sont statistiquement significatives (p = 0,00) tandis que les examens préparatoires passés (p = 0,52) ne sont pas statistiquement significatifs à α = 0,05. Étant donné que les examens préparatoires passés ne sont pas statistiquement significatifs, nous pourrions finir par décider de les supprimer du modèle.

Comment évaluer l’ajustement d’un modèle de régression linéaire multiple

Deux nombres sont couramment utilisés pour évaluer dans quelle mesure un modèle de régression linéaire multiple « s’adapte » à un ensemble de données :

1. R au carré : Il s’agit de la proportion de la variance de la variable de réponse qui peut être expliquée par les variables prédictives.

La valeur du R au carré peut varier de 0 à 1. Une valeur de 0 indique que la variable de réponse ne peut pas du tout être expliquée par la variable prédictive. Une valeur de 1 indique que la variable de réponse peut être parfaitement expliquée sans erreur par la variable prédictive.

Plus le R carré d’un modèle est élevé, plus le modèle est capable de s’adapter aux données.

2. Erreur standard : il s’agit de la distance moyenne entre les valeurs observées et la ligne de régression. Plus l’erreur type est petite, mieux un modèle est capable de s’adapter aux données.

Si nous souhaitons faire des prédictions à l’aide d’un modèle de régression, l’erreur type de la régression peut être une mesure plus utile à connaître que le R au carré, car elle nous donne une idée de la précision de nos prédictions en termes d’unités.

Pour une explication complète des avantages et des inconvénients de l’utilisation du R au carré par rapport à l’erreur standard pour évaluer l’ajustement du modèle, consultez les articles suivants :

Hypothèses de régression linéaire multiple

La régression linéaire multiple fait quatre hypothèses clés à propos des données :

1. Relation linéaire : Il existe une relation linéaire entre la variable indépendante, x, et la variable dépendante, y.

2. Indépendance : Les résidus sont indépendants. En particulier, il n’existe aucune corrélation entre les résidus consécutifs dans les données de séries chronologiques.

3. Homoscédasticité : Les résidus ont une variance constante à chaque niveau de x.

4. Normalité : Les résidus du modèle sont normalement distribués.

Pour une explication complète sur la façon de tester ces hypothèses, consultez cet article .

Régression linéaire multiple à l’aide d’un logiciel

Les didacticiels suivants fournissent des exemples étape par étape sur la manière d’effectuer une régression linéaire multiple à l’aide de différents logiciels statistiques :

Comment effectuer une régression linéaire multiple dans R

Comment effectuer une régression linéaire multiple en Python

Comment effectuer une régression linéaire multiple dans Excel

Comment effectuer une régression linéaire multiple dans SPSS

Comment effectuer une régression linéaire multiple dans Stata

Comment effectuer une régression linéaire dans Google Sheets