Taux d’erreurs de classification dans l’apprentissage automatique : définition & Exemple

Dans l’apprentissage automatique, le taux de classification erronée est une mesure qui nous indique le pourcentage d’observations qui ont été mal prédites par un modèle de classification .

Il est calculé comme suit :

Taux de classification erronée = # prédictions incorrectes / # prédictions totales

La valeur du taux de classification erronée peut varier de 0 à 1 où :

- 0 représente un modèle qui n’a eu aucune prédiction incorrecte.

- 1 représente un modèle dont les prédictions étaient complètement incorrectes.

Plus la valeur du taux de classification erronée est faible, plus un modèle de classification est capable de prédire les résultats de la variable de réponse .

L’exemple suivant montre comment calculer le taux d’erreur de classification pour un modèle de régression logistique dans la pratique.

Exemple : Calcul du taux d’erreurs de classification pour un modèle de régression logistique

Supposons que nous utilisions un modèle de régression logistique pour prédire si 400 joueurs de basket-ball universitaires différents seront recrutés ou non dans la NBA.

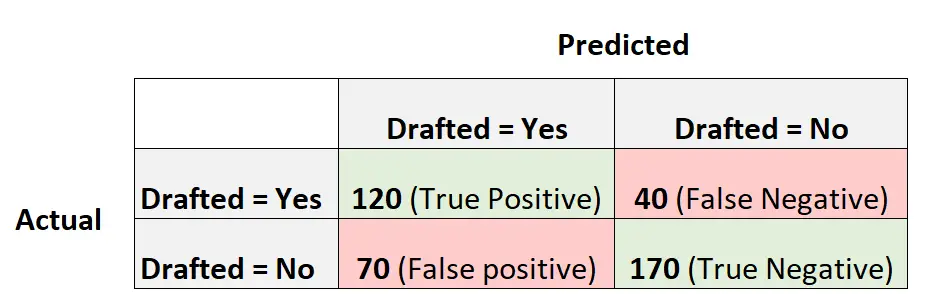

La matrice de confusion suivante résume les prédictions faites par le modèle :

Voici comment calculer le taux d’erreur de classification pour le modèle :

- Taux de classification erronée = # prédictions incorrectes / # prédictions totales

- Taux d’erreurs de classification = (faux positifs + faux négatifs) / (prédictions totales)

- Taux de mauvaise classification = (70 + 40) / (400)

- Taux de mauvaise classification = 0,275

Le taux d’erreur de classification pour ce modèle est de 0,275 ou 27,5 % .

Cela signifie que le modèle a mal prédit le résultat pour 27,5 % des joueurs.

L’opposé du taux d’erreur de classification serait l’exactitude, qui est calculée comme suit :

- Précision = 1 – Taux d’erreurs de classification

- Précision = 1 – 0,275

- Précision = 0,725

Cela signifie que le modèle a prédit correctement le résultat pour 72,5 % des joueurs.

Avantages et inconvénients du taux de classification erronée

Le taux de mauvaise classification offre les avantages suivants :

- C’est facile à interpréter . Un taux d’erreur de classification de 10 % signifie qu’un modèle a fait une prédiction incorrecte pour 10 % du total des observations.

- C’est facile à calculer . Un taux de classification erronée est calculé comme le nombre total de prédictions incorrectes divisé par le nombre total de prédictions.

Cependant, le taux d’erreurs de classification présente les inconvénients suivants :

- Cela ne tient pas compte de la manière dont les données sont distribuées . Par exemple, supposons que 90 % de tous les joueurs ne soient pas recrutés dans la NBA. Si nous avions un modèle qui prédit simplement que chaque joueur ne sera pas repêché, le modèle aurait un taux d’erreur de classification de seulement 10 %. Cela semble faible, mais le modèle est en fait incapable de prédire correctement un joueur qui sera repêché.

En pratique, nous calculons souvent le taux d’erreur de classification d’un modèle avec d’autres métriques telles que :

- Sensibilité : Le « vrai taux positif » – le pourcentage de résultats positifs que le modèle est capable de détecter.

- Spécificité : Le « vrai taux négatif » – le pourcentage de résultats négatifs que le modèle est capable de détecter.

- Score F1 : Une métrique qui nous indique la précision d’un modèle, par rapport à la façon dont les données sont distribuées.

En calculant la valeur de chacune de ces mesures, nous pouvons comprendre pleinement dans quelle mesure le modèle est capable de faire des prédictions.

Ressources additionnelles

Les didacticiels suivants fournissent des informations supplémentaires sur les concepts courants d’apprentissage automatique :

Introduction à la régression logistique

Qu’est-ce que la précision équilibrée ?

Score F1 vs précision : lequel devriez-vous utiliser ?