Qu’est-ce qu’un « bon » ? Précision pour les modèles d’apprentissage automatique ?

Lorsque nous utilisons des modèles de classification dans l’apprentissage automatique, une mesure que nous utilisons souvent pour évaluer la qualité d’un modèle est la précision .

La précision est simplement le pourcentage de toutes les observations correctement classées par le modèle.

Il est calculé comme suit :

Précision = (# vrais positifs + # vrais négatifs) / (taille totale de l’échantillon)

Une question que les étudiants se posent souvent à propos de l’exactitude est la suivante :

Qu’est-ce qui est considéré comme une « bonne » valeur pour la précision d’un modèle d’apprentissage automatique ?

Bien que la précision d’un modèle puisse varier entre 0 % et 100 %, il n’existe pas de seuil universel que nous utilisons pour déterminer si un modèle a une « bonne » précision ou non.

Au lieu de cela, nous comparons généralement la précision de notre modèle à celle d’un modèle de référence.

Un modèle de référence prédit simplement que chaque observation d’un ensemble de données appartient à la classe la plus courante.

En pratique, tout modèle de classification ayant une précision supérieure à un modèle de référence peut être considéré comme « utile », mais évidemment, plus la différence de précision entre notre modèle et un modèle de référence est grande, mieux c’est.

L’exemple suivant montre comment déterminer approximativement si un modèle de classification a une « bonne » précision ou non.

Exemple : Déterminer si un modèle a une « bonne » précision

Supposons que nous utilisions un modèle de régression logistique pour prédire si 400 joueurs de basket-ball universitaires différents seront recrutés ou non dans la NBA.

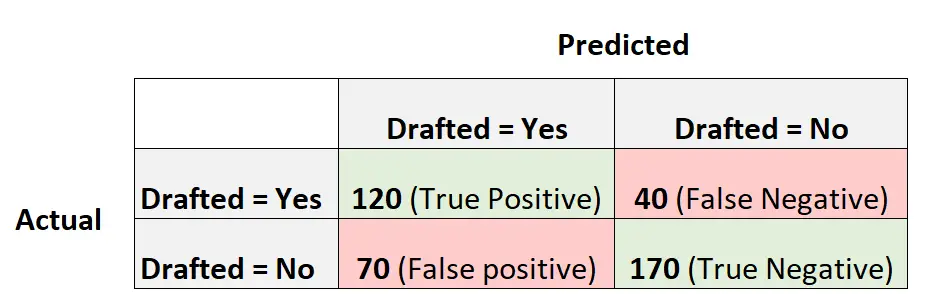

La matrice de confusion suivante résume les prédictions faites par le modèle :

Voici comment calculer la précision de ce modèle :

- Précision = (# vrais positifs + # vrais négatifs) / (taille totale de l’échantillon)

- Précision = (120 + 170) / (400)

- Précision = 0,725

Le modèle a prédit correctement le résultat pour 72,5 % des joueurs.

Pour avoir une idée si l’exactitude est « bonne » ou non, nous pouvons calculer l’exactitude d’un modèle de référence.

Dans cet exemple, le résultat le plus courant pour les joueurs était de ne pas être repêchés. Plus précisément, 240 joueurs sur 400 n’ont pas été repêchés.

Un modèle de base serait celui qui prédit simplement que chaque joueur ne sera pas repêché.

La précision de ce modèle serait calculée comme suit :

- Précision = (# vrais positifs + # vrais négatifs) / (taille totale de l’échantillon)

- Précision = (0 + 240) / (400)

- Précision = 0,6

Ce modèle de base prédirait correctement le résultat pour 60 % des joueurs.

Dans ce scénario, notre modèle de régression logistique offre une amélioration notable de la précision par rapport à un modèle de base, nous considérons donc notre modèle comme au moins « utile ».

En pratique, nous adapterions probablement plusieurs modèles de classification différents et choisirions le modèle final comme celui qui offre le plus grand gain de précision par rapport à un modèle de référence.

Précautions concernant l’utilisation de la précision pour évaluer les performances du modèle

La précision est une mesure couramment utilisée car elle est facile à interpréter.

Par exemple, si l’on dit qu’un modèle est précis à 90 %, on sait qu’il a correctement classé 90 % des observations.

Toutefois, l’exactitude ne tient pas compte de la manière dont les données sont distribuées.

Par exemple, supposons que 90 % de tous les joueurs ne soient pas recrutés dans la NBA. Si nous avions un modèle qui prédit simplement que chaque joueur ne sera pas repêché, le modèle prédirait correctement le résultat pour 90 % des joueurs.

Cette valeur semble élevée, mais le modèle est en réalité incapable de prédire correctement les joueurs qui seront repêchés.

Une mesure alternative souvent utilisée est appelée F1 Score , qui prend en compte la manière dont les données sont distribuées.

Par exemple, si les données sont fortement déséquilibrées (par exemple, 90 % de tous les joueurs ne sont pas repêchés et 10 % le sont), alors le score F1 fournira une meilleure évaluation des performances du modèle.

En savoir plus sur les différences entre la précision et le score F1 ici .

Ressources additionnelles

Les didacticiels suivants fournissent des informations supplémentaires sur les métriques utilisées dans les modèles de classification en apprentissage automatique :

Qu’est-ce que la précision équilibrée ?

Qu’est-ce qui est considéré comme un « bon » score F1 ?